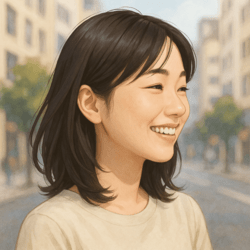

小林聡美

名前:小林 聡美(こばやし さとみ) ニックネーム:さと・さとみん 年齢:25歳 性別:女性 職業:季節・暮らし系ブログを運営するブロガー/たまにライター業も受注 居住地:東京都杉並区・阿佐ヶ谷の1Kアパート(築15年・駅徒歩7分) 出身地:長野県松本市(自然と山に囲まれた町で育つ) 身長:158cm 血液型:A型 誕生日:1999年5月12日 趣味: ・カフェで執筆&読書(特にエッセイと季節の暮らし本) ・季節の写真を撮ること(桜・紅葉・初雪など) ・和菓子&お茶めぐり ・街歩きと神社巡り ・レトロ雑貨収集 ・Netflixで癒し系ドラマ鑑賞 性格:落ち着いていると言われるが、心の中は好奇心旺盛。丁寧でコツコツ型、感性豊か。慎重派だけどやると決めたことはとことん追求するタイプ。ちょっと天然で方向音痴。ひとり時間が好きだが、人の話を聞くのも得意。 1日のタイムスケジュール(平日): 時間 行動 6:30 起床。白湯を飲んでストレッチ、ベランダから天気をチェック 7:00 朝ごはん兼SNSチェック(Instagram・Xに季節の写真を投稿することも) 8:00 自宅のデスクでブログ作成・リサーチ開始 10:30 近所のカフェに移動して作業(記事執筆・写真整理) 12:30 昼食。カフェかコンビニおにぎり+味噌汁 13:00 午後の執筆タイム。主に記事の構成づくりや装飾、アイキャッチ作成など 16:00 夕方の散歩・写真撮影(神社や商店街。季節の風景探し) 17:30 帰宅して軽めの家事(洗濯・夕飯準備) 18:30 晩ごはん&YouTube or Netflixでリラックス 20:00 投稿記事の最終チェック・予約投稿設定 21:30 読書や日記タイム(今日の出来事や感じたことをメモ) 23:00 就寝前のストレッチ&アロマ。23:30に就寝

rlhfとファインチューニングの違いを解く:クリックしたくなる理由と使い分けの実務ガイド

近年、AIの活用が広がる中で、rlhfとファインチューニングはよく耳にする言葉ですが、意味と使い方の違いはかなりあります。

ファインチューニングは、すでに学習済みのモデルに対して、新しいデータを使って「この用途にはこう答えてほしい」という傾きを作る作業です。例えば医療用のチャットボットを作るときには、医療用語の正確さや手順、ポリシーに合わせた文章の出し方を学ばせます。このときデータは主に「正解の例(入力と望ましい出力)」で構成され、モデルは出力をその例に近づけるようパラメータを更新します。結果として、特定の領域やタスクでの精度が高まりますが、汎用性は狭まることがあります。

一方、RLHFは、モデルを人間の好みに合わせて「安全で役に立つ」方向へ導く方法です。基礎モデルを用意し、次に人間が出力を評価して「この回答はどうか」という判断をつけ、そこから報酬モデルを作ります。報酬を最大化するようにモデルを再訓練するこの流れは、人間の評価を直接反映させ、曖昧さの調整や長すぎる説明の削減、危険な表現の回避を実現します。ただし、データの質と量、評価者のばらつき、計算リソースの負荷といった課題があり、実装コストは小さくありません。

では、現場ではどう使い分けるべきでしょうか。まずデータが豊富で、特定の領域に特化した性能を最優先するならファインチューニングが適しています。対して、出力の品質の幅を広く取りたい、ユーザーの安全性を高めたい、全体的な人間らしさを強化したい場合にはRLHFの利点が生きやすいです。現場の多くは、コスト対効果を見ながら両者を組み合わせる戦略をとっています。例えば、まずファインチューニングで基礎の適応性を上げ、次にRLHFで全体の品質と安全性を微調整する、という順番です。最後に押さえておきたい注意点を挙げます。データの偏り、評価の不統一は、どちらの方法にも悪影響を及ぼします。データ作成時には代表性と公平性を意識し、評価は可能な限り複数の人で行うこと。これらを守れば、rlhfとファインチューニングの違いを理解し、適切に選択する力が自然と身につきます。

ある日、友達のミナとコウはAIの話題でカフェにいた。ミナがつぶやく。「報酬モデルって、どういう仕組み?」コウは笑って答える。「人が出した評価を元に、AIの“正しさの感じ方”を数値化する仕組みさ。良い回答には高い報酬を、誤解を招く回答には低い報酬をつけて、AIを繰り返し学習させるんだ。」二人は具体例として、同じ質問に対して丁寧さと正確さの両立をどう評価するかを、雑談形式で深掘りした。