小林聡美

名前:小林 聡美(こばやし さとみ) ニックネーム:さと・さとみん 年齢:25歳 性別:女性 職業:季節・暮らし系ブログを運営するブロガー/たまにライター業も受注 居住地:東京都杉並区・阿佐ヶ谷の1Kアパート(築15年・駅徒歩7分) 出身地:長野県松本市(自然と山に囲まれた町で育つ) 身長:158cm 血液型:A型 誕生日:1999年5月12日 趣味: ・カフェで執筆&読書(特にエッセイと季節の暮らし本) ・季節の写真を撮ること(桜・紅葉・初雪など) ・和菓子&お茶めぐり ・街歩きと神社巡り ・レトロ雑貨収集 ・Netflixで癒し系ドラマ鑑賞 性格:落ち着いていると言われるが、心の中は好奇心旺盛。丁寧でコツコツ型、感性豊か。慎重派だけどやると決めたことはとことん追求するタイプ。ちょっと天然で方向音痴。ひとり時間が好きだが、人の話を聞くのも得意。 1日のタイムスケジュール(平日): 時間 行動 6:30 起床。白湯を飲んでストレッチ、ベランダから天気をチェック 7:00 朝ごはん兼SNSチェック(Instagram・Xに季節の写真を投稿することも) 8:00 自宅のデスクでブログ作成・リサーチ開始 10:30 近所のカフェに移動して作業(記事執筆・写真整理) 12:30 昼食。カフェかコンビニおにぎり+味噌汁 13:00 午後の執筆タイム。主に記事の構成づくりや装飾、アイキャッチ作成など 16:00 夕方の散歩・写真撮影(神社や商店街。季節の風景探し) 17:30 帰宅して軽めの家事(洗濯・夕飯準備) 18:30 晩ごはん&YouTube or Netflixでリラックス 20:00 投稿記事の最終チェック・予約投稿設定 21:30 読書や日記タイム(今日の出来事や感じたことをメモ) 23:00 就寝前のストレッチ&アロマ。23:30に就寝

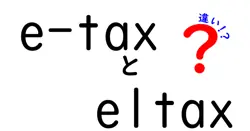

k-meansと階層的クラスタリングの違いを理解するための基本ガイド

ここでは k-means と 階層的クラスタリング の違いを、中学生にも分かる言葉で順に解説します。クラスタリングはデータを似たもの同士でグループ化する方法です。

まずは何をしたいのかをはっきりさせることが大切です。

例えば写真(関連記事:写真ACを三ヵ月やったリアルな感想【写真を投稿するだけで簡単副収入】)の中の色をまとめたいとき、データの性質や目的を前提として、両者の特徴と使い分けを丁寧に見比べます。

この解説では実務での使い方のコツも紹介します。

初期値の影響やデータの形状への対応、速度と正確さのトレードオフを順に整理します。

またクラスタ数の決め方や可視化の工夫、データ前処理のポイントも具体例を交えて説明します。

この章だけでなく、後のセクションで実際の使い分けの判断基準を身につけられるように設計しています。

k-meansの基本と特徴

k-means はデータ空間内に k 個の中心点を置き、データを最も近い中心点へ割り当てて中心点を更新していく反復的なアルゴリズムです。

距離の測り方は通常ユークリッド距離で、データが球状に集まる性質を前提に設計されています。

この点が手軽さの理由であり、実装も比較的簡単です。

しかしノイズが多いデータやクラスタの形が細長い場合には、中心点の位置だけでうまく分けられず、結果の解釈が難しくなることがあります。

初期の中心点の選び方は結果に大きく影響します。初期値をランダムにすると、実行ごとに異なる結果になることがあり得ます。

その対策として複数回走らせて最良の結果を採用する方法や、k-means++ のような賢い初期化法を使うことが一般的です。

この段落では初心者がつまずきやすい点と、実務での工夫を具体例とともに紹介します。

さらにデータ量が大きいときの対応策としてサンプリングやミニバッチ版の k-means などの工夫も役立つことを説明します。

階層的クラスタリングの基本と特徴

階層的クラスタリングはデータ間の距離をもとにデンドログラムと呼ばれる樹形図を作りながら、データを順に結合していく方法です。

この手法の魅力はクラスタの階層構造がそのまま見える点と、事前にクラスタ数を決めなくても良い点です。

クラスタをどの段階で切るかを後から決められるため、データの全体像を把握するには非常に有用です。

一方で計算量が多く、大規模なデータには時間がかかることがあります。

結果の解釈には注意が必要で、クラスタの分割はデータの測定値や距離の定義によって影響を受けます。データの分布が複雑な場合でも樹形図を使って視覚的に理解できる点が大きな利点です。この章ではどのようなデータで有効か、計算の目安、実務での活用のヒントを丁寧に解説します。

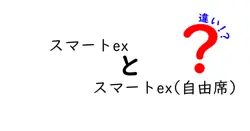

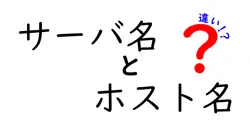

両者の違いをどう選ぶかの判断基準

違いを選ぶときにはまずクラスタ数を自分で決めたいかどうかを考えます。

k-means はクラスタ数をあらかじめ決める必要があり、最適な数を見つけるのが難しい場合があります。

階層的クラスタリングはクラスタ数を後から決定できる利点がありますが、データが大きいと処理時間が長くなりがちです。

データの性質を考えると、球状で均一な分布を想定する場面には k-means が向いています。

一方、データの構造が階層的に現れる場面やクラスタ数を事前に決定したくない場合には階層的クラスタリングが有利です。

また実務ではデータの規模ノイズの量クラスタの形探索の柔軟性などを総合的に判断します。

最後に、両方を試して比較するのが最も現実的なアプローチです。

この判断基準を日常のデータ分析にも取り入れると、中学生でも自分のデータに最適な方法を選びやすくなります。

この表を見れば、どちらを選ぶべきかを直感的に比べることができます。

実務ではデータの性質と分析の目的を軸に判断します。

なおクラスタリングは 100%正解を保証するものではなく、データの解釈の仕方の問題だということを忘れないでください。

その点を踏まえ、実際のデータに適用する前に小さなサンプルで比較して練習してみると、分析の技術が早く身につきます。

ねえ、クラスタリングの話をしていてふと思ったんだ。k-means って実は球の集合を作るゲームみたいだよね。初期の中心点をどう置くかでその後の運命が決まる。僕が試したときは初期値を変えるだけで、同じデータでも全然違う分け方になることがあって、友だちと笑いながら学習したのを覚えてる。だからこそ複数回実験して最も安定した結果を選ぶのが大事。k-means は手軽だけど魔法の杖ではない。階層的クラスタリングは木のように段階を追ってクラスタを作る仕組みだから、データの“針金のようなつながり”を可視化しやすい。どちらも万能ではないけど、データの性質をじっくり見極めるときには心強い味方になるんだ。