小林聡美

名前:小林 聡美(こばやし さとみ) ニックネーム:さと・さとみん 年齢:25歳 性別:女性 職業:季節・暮らし系ブログを運営するブロガー/たまにライター業も受注 居住地:東京都杉並区・阿佐ヶ谷の1Kアパート(築15年・駅徒歩7分) 出身地:長野県松本市(自然と山に囲まれた町で育つ) 身長:158cm 血液型:A型 誕生日:1999年5月12日 趣味: ・カフェで執筆&読書(特にエッセイと季節の暮らし本) ・季節の写真を撮ること(桜・紅葉・初雪など) ・和菓子&お茶めぐり ・街歩きと神社巡り ・レトロ雑貨収集 ・Netflixで癒し系ドラマ鑑賞 性格:落ち着いていると言われるが、心の中は好奇心旺盛。丁寧でコツコツ型、感性豊か。慎重派だけどやると決めたことはとことん追求するタイプ。ちょっと天然で方向音痴。ひとり時間が好きだが、人の話を聞くのも得意。 1日のタイムスケジュール(平日): 時間 行動 6:30 起床。白湯を飲んでストレッチ、ベランダから天気をチェック 7:00 朝ごはん兼SNSチェック(Instagram・Xに季節の写真を投稿することも) 8:00 自宅のデスクでブログ作成・リサーチ開始 10:30 近所のカフェに移動して作業(記事執筆・写真整理) 12:30 昼食。カフェかコンビニおにぎり+味噌汁 13:00 午後の執筆タイム。主に記事の構成づくりや装飾、アイキャッチ作成など 16:00 夕方の散歩・写真撮影(神社や商店街。季節の風景探し) 17:30 帰宅して軽めの家事(洗濯・夕飯準備) 18:30 晩ごはん&YouTube or Netflixでリラックス 20:00 投稿記事の最終チェック・予約投稿設定 21:30 読書や日記タイム(今日の出来事や感じたことをメモ) 23:00 就寝前のストレッチ&アロマ。23:30に就寝

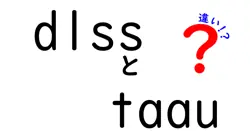

) dqn(ddqn 違いとは何か?基本をおさえよう

現在、強化学習の世界でよく聞く言葉に「DQN」と「DDQN」があります。DQNはDeep Q-Networkの略で、ニューラルネットワークを使って状態-行動価値関数Q(s,a)を推定します。従来のQ-learningを深層化したもので、経験再現(replay)とターゲットネットワークという工夫で学習を安定させるのが特徴です。ここでのアイデアは「行動を選ぶための最大Q値」と「そのQ値を更新するための別の推定」を同じネットワークで行うのではなく、固定されたターゲットネットワークと経験の反復再生を使う点にあります。

ただし、DQNは時には過剰推定という問題を起こすことがあり、特に難しい戦略や多くの行動がある環境では、最大のQ値をそのまま更新に利用することで、実際の最適値より高い値を過大評価してしまうことがあります。これが学習の進行を歪め、最適解に到達しにくくなる原因となることがあるのです。

この問題を解決するために生まれたのがDDQN(Double DQN)です。DDQNでは「行動の選択」と「価値の評価」を別々の推定に分けて、過剰推定を抑えるアイデアを取り入れます。つまり、現在のネットワークを使って次にとるべき行動を選び、その時の評価だけを別のネットワーク(ターゲットネットワーク)で行うのです。これにより、同じ瞬間に同じネットワークの2つの側面に依存していたのを避け、推定のバイアスを減らす効果が期待できます。

この違いを実感するには、実際の更新式を少しだけ触れておくと役立ちます。DQNのターゲットは r + γ max_a' Q_target(s', a') ですが、DDQNでは max_a' Q_main(s', a') を選択子として使い、評価は Q_target(s', a*) で行います。ここで a* は main ネットワークが選んだ行動です。こうした分離により、最終的な更新値の過大評価が減り、学習の安定性と収束性が向上することが多いのです。

この違いを理解しておくと、次のステップであるハイパーパラメータの調整や実験設計を考えるときに役立ちます。DQNは基礎的な枠組みとして強く推奨され、DDQNは実務での安定性を求める場面で選択されやすいです。環境の難易度やエピソードの長さ、観測ノイズの程度など、実務のシナリオに合わせて使い分けると良いでしょう。

- DQNの強みはシンプルさと広い適用性、経験再現とターゲットネットワークによる安定性です。

- DDQNの強みは過剰推定の軽減と、難しいタスクでの収束性の改善です。

これらの違いを理解しておくと、次のステップであるハイパーパラメータの調整や実験設計を考えるときに役立ちます。DQNは基礎的な枠組みとして強く推奨され、DDQNは実務での安定性を求める場面で選択されやすいです。環境の難易度やエピソードの長さ、観測ノイズの程度など、実務のシナリオに合わせて使い分けると良いでしょう。

研究室の雑談風にDDQNの話をしていたとき、友達がDQNは過大評価しがちだと指摘しました。私はDDQNでは行動の選択と評価を別のネットワークで分けるため、推定のバイアスが減ると説明しました。実験の曲線を見せながら、DQNとDDQNを比較するとDDQNの方が学習が安定し、報酬の変動が小さくなることを体感しました。こうした会話は、複雑なアルゴリズムも身近な言葉に置き換える練習になると感じました。